谷歌DeepMind发布Gemini Robotics 1.5:为具身智能打造新一代认知架构

爱力方

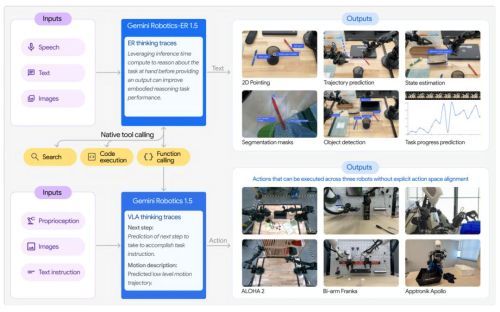

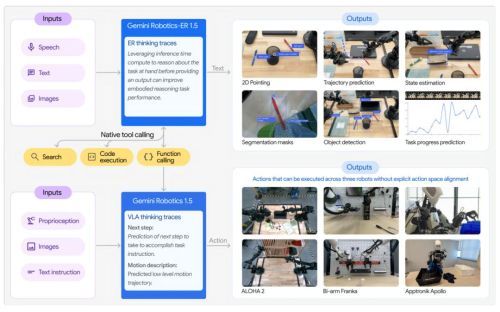

双模型协同:构建“思考-行动”的完整智能闭环

Gemini Robotics 1.5模型家族的核心在于其创新的双模型架构,旨在分离并优化机器人的“思考”与“行动”能力。

Gemini Robotics-ER 1.5 (Embodied Reasoning): 作为“战略大脑”,这是一款专为物理世界推理而优化的视觉-语言模型。它具备顶尖的空间理解能力,能够解析复杂指令,调用谷歌搜索等外部数字工具获取信息,并自主制定详细的多步骤任务计划。其能力包括物体检测、状态评估、任务成功率预测等。

Gemini Robotics 1.5 (Vision-Language-Action): 作为“执行核心”,这是一款先进的视觉-语言-行动模型。它接收来自ER模型的自然语言指令,并将其精准地转化为机器人的具体运动指令来完成物理操作。

这一协同框架显著提升了机器人处理长周期、复杂任务的泛化能力。ER模型负责宏观规划,而1.5模型则负责微观执行,共同实现了“先理解环境,再规划行动”的智能范式。

核心技术突破:内部推理与跨具身学习

Gemini Robotics 1.5系列引入了两项关键的技术突破,解决了机器人领域的长期挑战。

首先是“行动前思考”的内部推理能力。不同于传统VLA模型直接将指令映射为动作,Gemini Robotics 1.5在执行前能够以自然语言生成内部推理序列。这意味着它能对语义复杂的任务进行深度分析,使其决策过程更加透明,并能更好地处理多步骤流程。例如,在面对颜色分类任务时,机器人会先进行环境感知、颜色分析,再逐步规划并完成分拣动作。

其次是卓越的“跨具身学习”能力。机器人形态各异,将从一种形态学到的技能迁移至另一种形态一直是行业难题。Gemini Robotics 1.5证明了单一模型可以跨越不同物理形态的机器人进行部署。演示中,在一个机器人(Aloha)上获得的经验,能够被另一个形态完全不同且从未接触过该场景的机器人(Apollo)直接迁移使用,成功完成开门、取衣等全新动作。这一突破将极大加速通用机器人行为库的构建与迭代进程。

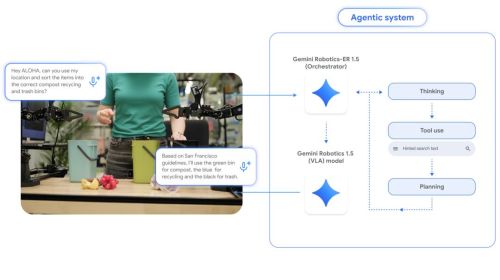

实际应用展示:从家庭助理到复杂任务处理

通过一系列演示,谷歌DeepMind展示了新模型赋予机器人的强大能力:

高级环境理解与工具调用: 在垃圾分类任务中,Aloha机器人能主动查阅旧金山的分类规则,并据此正确地将物品分拣至对应的垃圾桶。在打包行李任务中,Apollo机器人不仅执行了指令,还自主查询伦敦天气,并主动将雨伞放入行李箱。

复杂任务的链式规划与适应性: 在处理洗衣和打包等任务时,机器人展现了自主思考和动态调整的能力,例如主动调整篮子位置以便拾取衣物,或对环境中的突发变化做出即时反应。

这些应用表明,搭载Gemini Robotics 1.5的机器人已不再是简单的指令执行者,而是能够理解意图、规划步骤并与物理世界进行智能交互的“新物种”,为机器人在家庭、物流、零售等真实场景的广泛应用奠定了坚实基础。