作者:李鑫 出品:具身智能大讲堂

机器人领域长期存在一个关键问题:基于特定机器人训练的操作技能,难以直接应用到其他型号机器人上。不同机械臂结构、末端执行器形态差异,导致机器人技能复用困难。

其中的核心原因在于数据偏见。当前大规模机器人操作数据集分布失衡,多集中在Franka Panda、xArm等少数平台,末端执行器以平行夹爪为主。这种单一数据使得训练出的模型过拟合,面对不同形态机器人时,泛化能力不足,无法实现有效技能迁移。

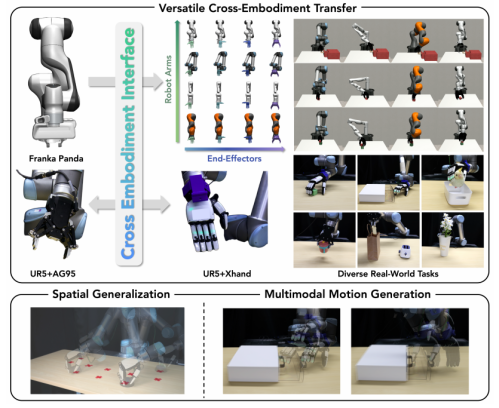

近日,由清华大学深圳国际研究生院、南洋理工大学机械与航空航天工程学院联合研发团队开发了Cross-Embodiment Interface(CEI)跨形态学习框架,该框架跳出机器人物理形态限制,通过功能相似性技术,实现不同机器人间高效技能迁移。仿真与真实场景验证显示,CEI可将Franka Panda的技能迁移到16种不同形态机器人,支持UR5+AG95夹爪机器人与UR5+Xhand灵巧手双向迁移,平均成功率达82.4%。

目前该研究成果已被 IEEE Robotics and Automation Letters (RA-L)接收,论文第一作者为清华大学博士生吴同、清华大学博士,南洋理工大学博士后李寿杰。通讯作者为清华大学深圳国际研究生院副教授丁文伯。

PART 01

告别形态束缚 CEI三步实现平行夹爪与灵巧手技能无缝迁移

传统跨形态迁移方法局限于平行夹爪场景,难以应对多指灵巧手等复杂末端执行器。CEI的创新点在于发现不同机器人完成同一任务时,末端执行器与物体交互的核心功能逻辑相通,即“功能相似性”。

如同人类抓握瓶子时会采用类似夹爪的姿势保证受力稳定,这种底层交互逻辑是平行夹爪与灵巧手之间技能迁移的桥梁。CEI通过三步实现技能迁移:

-

功能表征:构建机器人交互特征

CEI为每个机器人构建“功能表征”,记录与物体交互的关键信息。在机器人末端执行器表面选取可能与物体接触的点,同时记录每个接触点的表面法线方向,这些点与方向的组合构成机器人“交互能力画像”。

通过正向运动学技术,将接触点和方向统一转换到同一空间坐标系,确保不同机器人的“交互能力画像”可直接对比。该表征不关注机器人外观和结构细节,仅聚焦“如何与物体交互”的核心功能。

2. 相似度量化:匹配交互逻辑

CEI采用兼顾空间位置和方向的度量方法,衡量两个机器人“交互能力画像”的相似度。既计算接触点之间的空间距离,也考量接触方向的一致性,得出综合相似度评分。评分越高,交互逻辑越接近,技能迁移难度越低。

这种量化方式弥补了传统方法仅关注空间位置、忽略交互方向的缺陷,提升了不同形态机器人功能匹配的精准度。

3. 轨迹对齐与数据生成:落地可用技能

基于功能相似度评分,CEI通过梯度优化技术,将源机器人操作轨迹适配到目标机器人。以源机器人交互轨迹为参考,调整目标机器人关节运动,使目标机器人“交互能力画像”贴近源机器人。

为保证轨迹连贯性,CEI采用序列优化策略,后一帧关节运动初始化沿用前一帧优化结果,加快适配速度,避免轨迹跳跃或断裂,确保生成轨迹可平稳执行。

轨迹对齐后,CEI为目标机器人生成完整演示数据:

动作生成:将目标机器人下一帧关节位置作为当前动作指令,采用闭环控制策略,确保机器人准确到达目标位置;

观测生成:关节状态信息取自对齐后的轨迹;视觉观测通过“裁剪-增强-下采样”标准化流程生成,先移除源机器人视觉信息,补充目标机器人视觉数据,再调整为固定格式,保证与训练数据一致。

PART 02

实验验证:仿真与真实场景均达高效迁移

研究团队在仿真和真实世界开展大规模实验,覆盖多种任务和机器人形态,验证CEI性能。

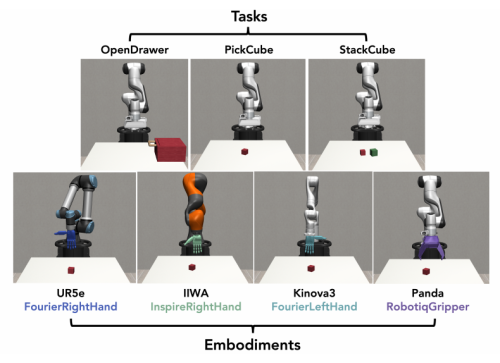

仿真实验:16种机器人+3类任务,迁移效果稳定

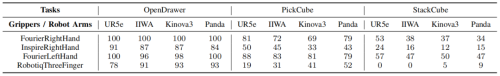

仿真实验基于robosuite平台,选用4种机械臂(UR5e、IIWA、Kinova3、Franka Panda)和4种末端执行器(FourierRightHand、InspireRightHand、FourierLeftHand、RobotiqThreeFinger),组合成16种机器人形态。

实验任务包括开门、抓立方体、叠立方体,演示数据来自Franka Panda的人工遥操作记录,通过CEI迁移到其他15种机器人。

仿真环境下跨任务与跨形态组合的完整评估

结果显示:

简单任务表现优异,开门任务中多个机器人形态成功率达100%;

抓立方体任务中,Fourier系列灵巧手成功率稳定在80%以上;

灵巧手整体表现优于三指夹爪,FourierRightHand和FourierLeftHand在所有任务中保持高成功率;RobotiqThreeFinger在叠立方体任务中表现较差,受限于运动学结构,接触稳定性不足。

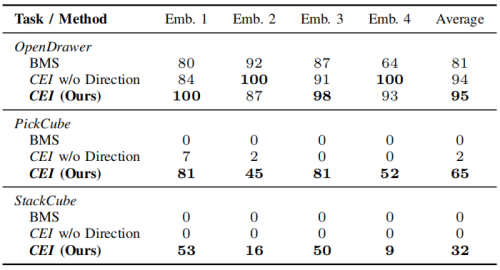

消融实验:关键组件不可或缺

为明确CEI各核心组件作用,研究团队设计两组对比实验:

跨形态技术的消融实验

仅保留位置信息:移除功能表征中的方向信息,仅基于接触点空间位置迁移,平均成功率仅32%,无法完成抓握类任务,证明方向信息对抓握动作迁移至关重要;

手动指定动作:人工设定末端执行器开合动作,强制匹配源机器人夹爪开度,抓握和叠放任务成功率为0,开门任务也因运动学差异频繁失败,凸显CEI自动适配策略的优势。

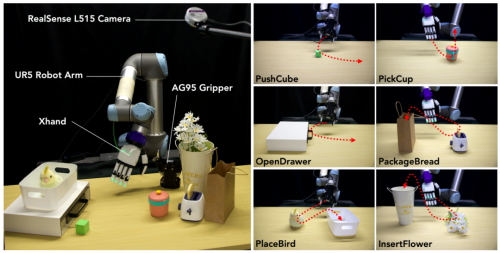

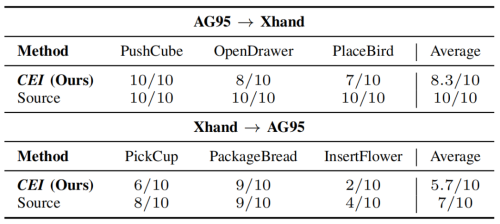

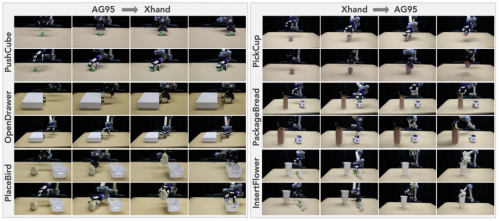

真实世界实验:双向迁移覆盖6类任务

真实世界实验以UR5机械臂为基础平台,搭配AG95平行夹爪和Xhand灵巧手,开展双向技能迁移,涵盖6类日常任务:

左图:真实世界实验的装置及相关物体。

右图:真实世界任务。

AG95→Xhand:推立方体、开门、将玩具鸟放入盒子;

Xhand→AG95:抓杯子、将面包装入袋子、将花插入花瓶。

每组任务收集25条源机器人演示数据,经CEI迁移到目标机器人后,进行10次重复测试。

结果显示:

推立方体任务实现完美迁移,目标机器人与源机器人成功率均为100%;

装面包任务中,Xhand到AG95迁移成功率达90%,与源机器人持平;

6个任务平均成功率70%,源机器人平均成功率85%,迁移比(CEI成功率/源机器人成功率)达82.4%;

失败集中在需精细接触的任务,如开门时灵巧手手指滑落、插鲜花时花茎过细导致抓握不稳定,这类问题源于任务本身难度,源机器人也难以完全避免。

效率对比:数据生成高效实用

数据生成效率是框架实用性的关键指标。研究团队将CEI与两种主流数据生成方法对比:MimicGen(在线数据生成):依赖物理仿真或真实机器人在线执行,生成400条演示需25.6小时,效率极低;DemoGen(离线数据生成):生成速度快,400条演示仅需1.14秒。CEI:平衡效率与质量,生成400条可用演示仅需3.6分钟,可快速扩充数据集,且保证轨迹可执行性,满足策略训练需求。

PART 03

拓展能力:空间泛化与多模态运动拓展应用场景

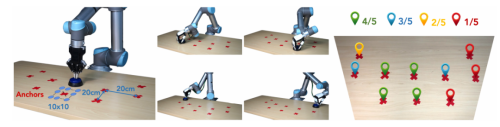

CEI不仅支持跨形态迁移,还具备空间泛化和多模态运动生成能力,扩大机器人技能应用范围。空间泛化能力。左图:实验装置及任务配置,各锚点间距 20 厘米。在每个锚点周围,团队在 [-8 厘米,8 厘米] 范围内采样 10×10 网格用于数据生成。中图:研究团队的方法可使 Xhand 灵巧手在桌面大部分区域完成按钮按压任务。右图:10 个锚点的评估结果,每个锚点重复测试 5 次,结果以不同颜色区分。

空间泛化:单一演示覆盖全工作空间

CEI通过空间变换技术,从单个演示轨迹生成覆盖整个工作空间的多样化数据。例如,仅收集一次“在桌子左侧按压按钮”的演示,即可自动生成“在桌子任意位置按压按钮”的大量数据。测试中,研究团队从一个初始演示出发,生成覆盖10个不同区域、共1000条演示数据。训练后的机器人能在桌子大部分区域成功完成按压按钮任务,突破原始演示位置限制。

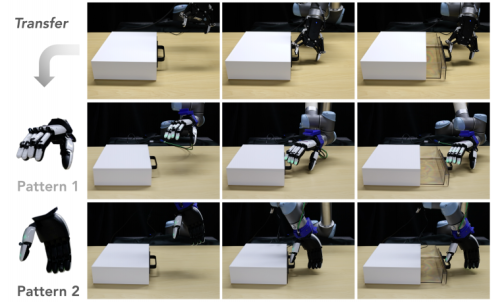

多模态运动生成:同一任务多种执行方式

通过优化初始关节配置选择策略,CEI可为同一任务生成多种运动模式。例如开门任务中,CEI生成两种操作方式:指尖插入把手拉动、侧面夹持把手拉动,成功率分别为80%和70%。

CEI 的多模态能力。基于同一演示样本,CEI 在开门任务中可生成两种不同的操作动作模式。

将不同模式演示数据混合训练,策略成功率未下降,说明多样化数据可提升策略鲁棒性,使其适应不同初始条件或环境变化。

PART 04

结语与未来

CEI为机器人跨形态学习提供了统一、高效、通用的解决方案。通过“功能相似性”突破物理形态束缚,实现平行夹爪与灵巧手间的极端形态迁移,在仿真和真实场景中均表现出领先性能。

与传统方法相比,CEI通用性强,支持多种形态双向迁移;数据效率高,少量源演示数据即可生成大量目标机器人可用数据,降低人工演示收集成本;拓展性好,可集成空间泛化和多模态生成能力,适应复杂应用场景。

目前,CEI主要依赖视觉和关节运动信息,难以检测滑动等不稳定接触状态;面对超大规模数据集时,优化效率仍有提升空间。未来,融合触觉传感技术、优化算法架构,CEI有望在更广泛场景发挥作用,推动“一次训练,多机复用”的机器人学习新范式落地,加速机器人技术规模化应用。

论文链接:https://cross-embodiment-interface.github.io/static/pdf/CEI.pdf

项目地址:https://cross-embodiment-interface.github.io/