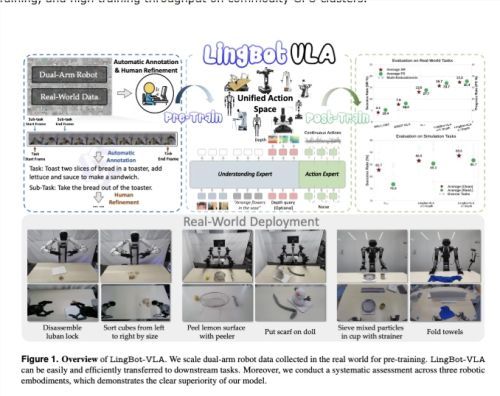

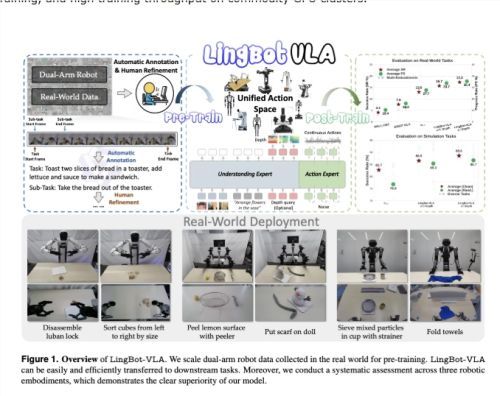

蚂蚁集团近日正式发布了名为 LingBot-VLA 的视觉-语言-动作(VLA)基础模型。 该模型专注于现实世界中的机器人复杂操控,通过海量数据训练,实现了在不同形态机器人上的通用操控能力,标志着具身智能领域取得又一重要进展。

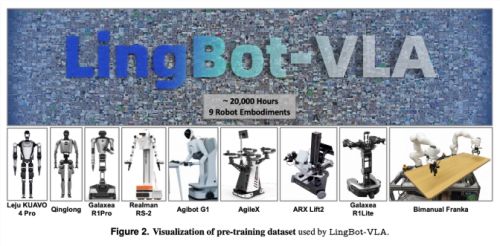

为了构建这一强大的模型,研发团队在 AgiBot G1、AgileX 等9种主流双臂机器人上采集了约2万小时的真实遥操作数据。 这些数据涵盖了丰富的动作序列,并由 Qwen3-VL 自动生成详细的语言指令,形成了一套高质量的预训练数据集。

LingBot-VLA 采用了创新的“混合 Transformer”架构。 它以 Qwen2.5-VL 作为多模态主干,能够同时处理多视角图像和自然语言指令。 与此同时,模型内置的“动作专家”分支会实时结合机器人的自身状态,通过条件流匹配技术,输出平滑且连续的控制轨迹,确保了双臂协作的精准度。

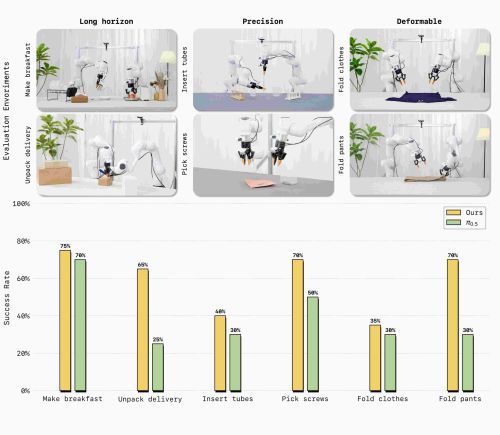

此外,针对传统模型在空间深度感知上的弱点,蚂蚁集团引入了 LingBot-Depth 空间感知模型。 通过特征蒸馏技术,LingBot-VLA 即使在传感器数据缺失的情况下,也能展现出卓越的3D 空间推理能力,在叠放、插入、折叠等精细化任务中表现尤为出色。

在包含100项挑战任务的 GM-100现实世界基准测试中,带深度感知版本的 LingBot-VLA 成功率达到17.30%,显著优于 π0.5和 GR00T N1.6等同类模型。 研究还发现,该模型具有极高的数据效率,仅需约80条特定任务的演示数据,即可快速适配新机器人。

目前,蚂蚁集团已将 LingBot-VLA 的全套训练工具包和模型权重正式开源。 该工具包针对大规模 GPU 集群进行了优化,训练吞吐量比现有主流框架提升了1.5至2.8倍。 这一举措将极大降低机器人大模型的开发门槛,推动具身智能技术向更多实际应用场景渗透。

论文:https://arxiv.org/pdf/2601.18692