如何通过基于优先级的架构和新的法律模型使机器人行为可预测

一个特斯拉 Optimus 人形机器人在工厂里与人们一起行走。可预测的机器人行为需要基于优先级的控制和法律框架。来源:特斯拉

一个特斯拉 Optimus 人形机器人在工厂里与人们一起行走。可预测的机器人行为需要基于优先级的控制和法律框架。来源:特斯拉

机器人正变得越来越智能,行为也更加可预测。Tesla Optimus在工厂中搬运箱子,Figure 01冲泡咖啡,而Waymo则在没有司机的情况下载客。这些技术已不再是演示品,它们正越来越多地进入现实世界。

但随之而来的核心问题是:我们如何确保机器人在复杂情况下能够做出正确的决策?如果它同时收到来自不同人的两个相互冲突的命令,会发生什么?我们如何能够确信它不会违反基本安全规则——即使是在其主人的要求下?

为什么传统系统会失败?大多数现代机器人基于预定义脚本运行——一组命令和一组反应。在工程术语中,这些是行为树、有限状态机,有时是 machine learning。这些方法在受控环境中效果良好,但在现实世界中的命令可能会相互矛盾。

此外,环境变化的速度可能快于机器人的适应能力,并且对于当前紧要事项,缺乏明确的"优先级映射"。因此,系统可能会犹豫不决或选择错误的场景。对于自动驾驶汽车或人形机器人而言,这种可预见的犹豫不再仅仅是一个错误——而是一种安全风险。

从反应式到基于优先级的控制

如今,大多数自主系统都是反应式的——它们对外部事件和命令做出响应,仿佛这些事件和命令具有同等重要性。机器人接收到信号后,会从内存中检索匹配的场景并执行,而不考虑该场景如何融入更大的目标。

因此,可预测的命令和事件在同一优先级上竞争。长期任务容易被即时刺激中断,在复杂环境中,机器人可能会胡乱行动,试图满足每一个输入信号。

除了日常运行中的这些问题外,始终存在技术故障的风险。例如,在本月于北京举行的首届世界人形机器人运动会(World Humanoid Robot Games)上,来自宇树科技(Unitree)的H1机器人偏离了其最优路径,并将一名人类参赛者撞倒在地。

类似的情况早些时候在中国发生过:在维护工作期间,一个机器人突然开始胡乱挥动它的手臂,击打工程师,直到它被切断电源。

这两起事件清楚地表明,现代自主系统常常在不分析后果的情况下做出反应。在缺乏上下文优先级的情况下,即使是微小的技术故障也可能升级为危险情况。

没有内置安全优先级逻辑以及与主体(如人类、机器人和物体)交互管理功能的架构,无法针对此类情况提供任何保护。

我的团队设计了一种架构,将行为从"刺激-反应"模式转变为有意识的选择。每个事件首先通过任务和主体过滤器,在环境和后果的背景下进行评估,然后才进入执行阶段。这使得机器人能够可预测地、一致地和安全地行动——即使在动态和不可预测的条件下也是如此。

两个层次:行动中的优先级

我们设计了一种直接解决可预测机器人技术和反应性问题的控制架构。其核心是两个相互关联的层次结构。

任务层级— 一个结构化的目标优先级系统:

- 战略性任务——基础且不可改变:"不要伤害人类","协助人类","遵守规则。"

- 用户任务——由所有者或操作员设定的任务

- 当前任务——可被中断以便处理更重要任务的次要任务

2. 交互主体层次结构— 根据来源对命令和交互进行优先级排序:

- 最高优先级 — 所有者、管理员、操作员

- 二级 — 授权用户,例如家庭成员、员工或分配的机器人

- 外部参与者——在情境分析中被考虑但不能控制系统的其他人、动物或机器人

可预测控制的实际工作原理

案例1. 人形机器人 —一个机器人正在装配线上运送零件。参观团中的一个孩子要求它交出一个重型工具。这个请求来自一个外部方。这个任务潜在不安全,且不属于当前任务的一部分。

- 决定:忽略该命令并继续工作。

- 结果:孩子和生产过程都保持安全。

案例2. 自动驾驶汽车— 一名乘客要求加速以避免迟到。传感器检测到道路上有冰。该请求来自一个高优先级主体。但战略任务"确保安全"比便利更重要。

- 决策:车辆不加速,并重新规划路线。

- 结果:安全拥有绝对优先级,即使对用户造成不便。

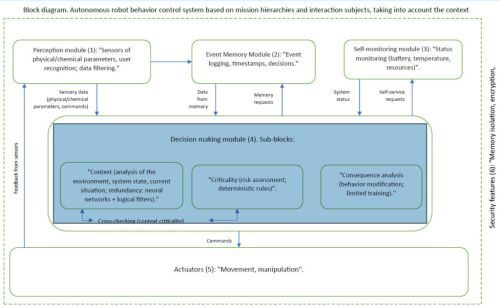

可预测决策的三个过滤器

每个命令都通过三级验证:

- 上下文环境,机器人状态,事件历史

- 关键性— 该行动会有多危险

- 结果— 如果执行或拒绝该命令,将会发生什么变化

如果任何过滤器触发警报,系统将重新考虑该决策。从技术角度看,该架构是根据下面的框图实现的:

一种解决机器人反应性的控制架构。来源:郑吉斯·泰勒贝(Zhengis Tileubay)

法律方面:中立-自治地位

我们超越了技术架构的范畴,提出了一种新的法律模型。为了准确理解,必须用正式的法律语言对其进行描述。人工智能和人工智能驱动的自主系统的"中性自主地位"是一个法律认可的类别,在此类别中,这类系统既不被视为像工具一样的传统法律责任客体,也不被视为像自然人或法人一样的法律主体。

这一地位引入了一个新的法律类别,消除了AI监管中的不确定性,并避免了在定义其法律性质方面的极端做法。现代法律体系基于两个主要类别运作:

- 法律主体— 享有权利和承担义务的自然人和法人

- 法律客体— 由主体控制的物品、工具、财产和无形资产

AI和自主系统不属于任何一类范畴。如果被视为物体,全部责任将完全由开发者和所有者承担,使他们面临过度的法律风险。如果被视为主体,它们则面临一个根本问题:缺乏法律能力、意图以及承担义务的能力。

因此,有必要建立第三种类别——中性自主状态,以构建一个平衡的责任与义务框架。

中立自主地位的法律机制

核心原则是,每个AI或自主系统都必须被分配明确界定的任务,这些任务设定了其目的、自主范围和责任法律框架。任务作为法律边界,限制了AI的行为并决定了责任分配。

法院和监管机构应基于自主系统被分配的任务来评估其行为,确保结构化的问责机制。开发者和所有者仅在其被分配的任务范围内承担责任。如果系统在这些任务范围之外行动,则责任由偏离的具体情况决定。

故意超出其指定任务范围利用系统的用户可能面临增加的责任。

在出现不可预见行为的情况下,当系统行为仍在指定任务范围内时,将适用责任缓解机制。如果系统在其定义的参数和任务范围内运行,开发者和所有者可免于承担全部责任。如果用户诚信地使用系统且未导致异常,他们同样可以从责任缓解机制中受益。

假设的例子

一辆自动驾驶汽车撞到了一名突然在人行横道外跑到高速公路上的行人。系统的任务:"在交通法规下确保乘客安全送达"和"在系统技术能力范围内避免碰撞",通过检测安全刹车所需的足够距离来实现。

受伤方要求自动驾驶汽车制造商赔偿1000万美元。

场景1:任务合规行人在前方11米处出现(以80公里/小时或50英里/小时的速度行驶时,相当于0.5秒的反应时间)—这超出了约40米(131.2英尺)的安全制动距离。车辆开始制动但未能及时停下。法院裁定汽车制造商符合任务合规要求,因此将责任赔偿减至50万美元,并认定行人承担部分责任。储蓄950万美元

场景2:任务校准错误。在夜间,由于摄像头校准错误,汽车将行人误分类为静态物体,导致制动延迟了0.3秒。这次,汽车制造商对配置错误负有责任——赔偿金额为500万美元,而非1000万美元,这得益于状态定义。

场景3:用户任务违规车主无视警告,将车辆驶入禁止进入的施工区域。1000万美元的全部责任由车主承担。自动驾驶汽车公司因使用规定被违反而免于承担责任。

这个例子展示了中立自主状态如何构建责任,根据具体情况保护开发者和用户。

中性自主状态带来商业和监管优势

随着中性自主状态的实施,法律风险得以降低。开发者免受与系统行为相关的不当诉讼,用户可以依赖可预测的责任框架。

监管机构将获得结构化的法律基础,减少裁决中的不一致性。涉及AI的法律纠纷将从任意的先例转变为统一的框架。针对AI自主性水平和任务复杂性的新分类系统可能会出现。

较早采取中立立场的公司可以降低法律风险,并更有效地管理 AI 系统。开发者将在法律认可的参数范围内获得更大的自由度来测试和部署系统。企业可以将自己定位为道德领导者,从而提升声誉和竞争力。

此外,政府将获得一种平衡的监管工具,既能保持创新又能保护社会。

为什么可预测的机器人行为很重要

我们正处于人形机器人和自动驾驶车辆大规模部署的门槛上。如果我们今天未能建立健全的技术和法律基础,那么未来风险可能会超过收益——公众对机器人的信任也可能被削弱。

建立在任务和主体层级结构之上,并结合中立自主状态的架构,是下一阶段可预测机器人技术能够安全发展的基础。

该架构已在专利申请中描述。我们已准备好与人形机器人、自动驾驶车辆及其他自主系统的制造商开展试点合作。

编者按:2025年RoboBusiness大会将于10月15日至16日在加利福尼亚州圣克拉拉市举行,会议将设置具身人工智能(physical AI)、使能技术、人形机器人(humanoids)、野外机器人、设计与开发以及商业最佳实践等主题分会场。注册现已开放。